随着计算机硬件市场的快速发展与个性化需求的日益增长,用户在选择电脑配置时常常面临信息过载与专业门槛高的困境。针对这一问题,本研究提出并实现了一个基于Django框架、集成论坛数据与Python网络爬虫技术的智能电脑配置推荐系统。该系统旨在通过自动化收集、分析与整合网络上的硬件信息与用户评价,为用户提供个性化、数据驱动的配置推荐方案。

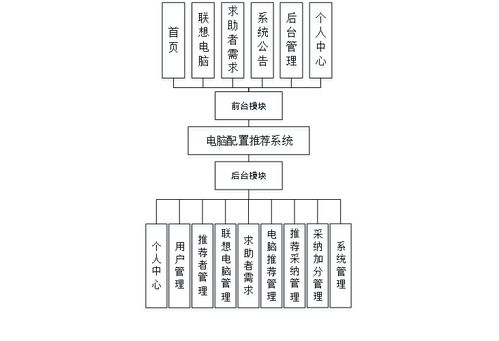

一、 系统架构与核心技术

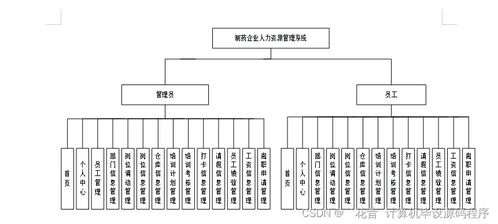

本系统采用经典的MVC(模型-视图-控制器)设计模式,以Django作为后端Web开发框架。其核心架构主要包括以下三个模块:

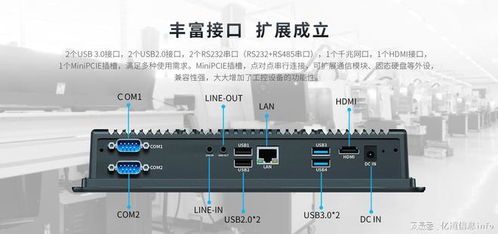

- 数据采集模块:利用Python的Scrapy或Requests+BeautifulSoup库构建网络爬虫。爬虫目标锁定为大型硬件论坛(如Chiphell、百度贴吧相关板块)、电商产品页面以及专业评测网站。爬取内容涵盖CPU、GPU、内存、主板等核心硬件的规格参数、实时价格、用户发帖与回帖中的使用体验、性能评价、兼容性反馈及热度讨论。

- 数据处理与存储模块:对爬取的原始数据进行清洗、去重和结构化处理。使用正则表达式和自然语言处理技术(如基于SnowNLP或jieba的情感分析)从论坛文本中提取有效信息,例如将“散热很好”、“性价比高”等描述转化为量化指标。处理后的数据存储于MySQL数据库中,Django的ORM层用于高效的数据操作与建模。

- 推荐算法与Web服务模块:这是系统的智能核心。算法部分综合考虑用户输入(预算、主要用途如游戏、设计、办公)、硬件性能天梯榜、市场热度、论坛口碑以及配置均衡性(避免瓶颈)。采用基于内容的推荐与协同过滤相结合的混合推荐模型。Django负责构建整个Web应用,包括用户交互界面、表单处理、逻辑控制以及动态渲染推荐结果页面。

二、 开发流程与关键实现

- 需求分析与设计:明确系统需支持按预算、用途筛选,展示配置清单、总价、性能点评及相关的论坛口碑摘要。设计数据库模型,定义用户画像、硬件条目、论坛帖子、配置方案等实体及关系。

- 爬虫开发与数据治理:编写健壮的爬虫程序,遵守Robots协议,设置合理的请求间隔。建立定时任务(如使用Celery),实现数据的增量更新。数据治理环节尤为重要,需要建立一套关键词库与规则,以准确提取非结构化的论坛意见。

- 推荐模型构建:初期可采用规则引擎(例如:游戏用途优先分配高预算给GPU),后期融入机器学习模型,利用历史用户选择行为数据进行训练,优化推荐准确性。模型可以封装为独立的Python服务或直接集成在Django应用中。

- Django应用集成:开发Django的视图(Views)处理用户请求,模板(Templates)展示配置对比图表和口碑摘要,路由(URLs)设计清晰的访问路径。利用Django REST framework可额外提供API接口,供移动端或其他应用调用。

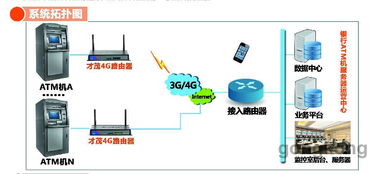

- 测试与部署:进行功能测试、性能测试及爬虫稳定性测试。最终项目可部署在Nginx + Gunicorn + Django的经典Linux服务器环境中,并使用Redis作为缓存提升响应速度。

三、 研究价值与创新点

本研究及所开发的系统,其价值在于:

- 信息聚合:将分散的硬件参数、市场价格和主观口碑进行一站式整合,解决了信息碎片化问题。

- 决策支持:通过算法将专业硬件知识转化为易懂的推荐建议,降低了普通用户的决策难度。

- 动态适应性:爬虫确保了数据的时效性,使推荐能紧跟市场新品发布和价格波动。

- 社区智慧利用:创新性地将论坛的“人”的经验与评价纳入推荐系统,弥补了纯参数对比的不足,使推荐结果更具实践参考价值。

四、 挑战与展望

项目开发中也面临若干挑战:论坛文本分析的准确性、爬虫对网站改版的适应性、避免推荐方案过于同质化等。未来工作可着眼于引入更先进的NLP模型进行细粒度情感分析,增加用户反馈循环以优化算法,并探索对二手硬件市场的配置推荐支持。

这款基于Django与Python爬虫的电脑配置推荐系统,是数据挖掘技术与Web工程实践的有效结合。它不仅是一个实用的软件工具,也为研究如何利用网络公开信息构建垂直领域的决策支持系统提供了有益的案例参考。